About Statista

世界をリードするデータプラットフォーム

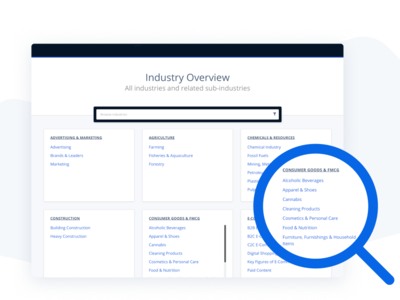

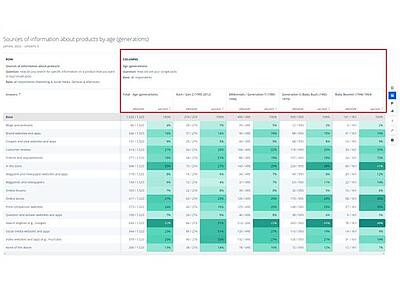

Statista(スタティスタ)は、ドイツ・ハンブルクに本社を置く統計データ会社です。170以上の業種・業界、150以上の国・地域の統計データを190万点以上、また、80,000件以上のトピックに関する調査レポートや予測データ、消費者調査ツール、調査代行サービスを提供しています。

全世界で23,000社を超えるお客様がデータに基づく迅速な意思決定にStatistaを活用しています。世界最大級の統計データプラットフォームStatistaで、最新の市場動向を把握しましょう。